ندا اظهری، مترجم: دسامبر سال گذشته بود که نخستین اخبار مرتبط با ظهور نرمافزار ChatGPT در دنیا سر و صدای زیادی را به پا کرد و حتی دانشمندان و محققان را بر آن داشت تا خواستار توقف ششماهه هوش مصنوعی در دنیا شوند تا بتوانند این فناوری را تحت کنترل بگیرند اما غافل از اینکه ChatGPT در همان مدت زمان کمی که از ظهورش میگذرد کاربران بسیاری را از دانشجو تا استاد و محقق به خود جلب کرده است. در ادامه بهرغم توانمندیهایی که این نرمافزار دارد محققان نسبت به پیشرفت آن و نیز کارهایی که میتواند انجام دهد ابراز نگرانی کردند و حالا nature در گزارشی که منتشر کرده به این موضوع پرداخته است که ChatGPT و ابزارهای هوش مصنوعی میتوانند فرآیند انتشار مقالات علمی را با اختلال مواجه کنند.

مقالات نه برای نوشتن بلکه برای تولید علم

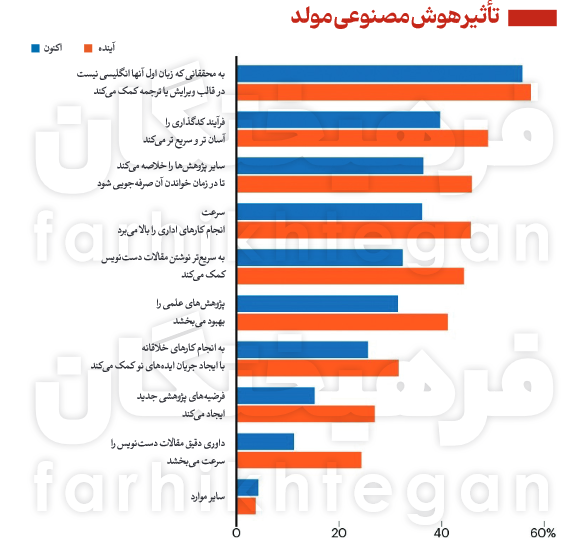

زمانی که «دومنیکو ماستردیکاسا» رادیولوژیست حین نوشتن مقاله پژوهشی خود به بنبست میرسد به نرمافزار هوش مصنوعی ChatGPT رومیآورد؛ ربات چتی که تنها در چند ثانیه تقریبا به هر سوالی پاسخی میدهد. این رادیولوژیست که در دانشکده پزشکی دانشگاه واشنگتن واقع در سیاتل فعالیت میکند، عنوان کرده است که من از این نرمافزار بهعنوان ابزاری برای تولید سریعتر مقالاتم استفاده میکنم. او یکی از بسیار محققانی است که از ابزارهای هوش مصنوعی مولد برای نوشتن متن یا کد استفاده میکنند. نسخه اشتراکی این نرمافزار بر پایه مدل زبانی بزرگ (large language model) GPT-4 استوار بوده و تنها هفتهای چند بار از آن استفاده میکند. مجله natureعنوان کرده است دانشمندانی که بهطور مداوم از مدل LLM استفاده میکنند هنوز در اقلیت قرار دارند. در این میان، بسیاری از محققان انتظار دارند که ابزارهای هوش مصنوعی مولد همواره بهعنوان دستیارانی برای نوشتن دستنوشتهها، گزارشها و برنامههای کمک مالی تبدیل شوند. اینها تنها برخی از راههایی هستند که در آن هوش مصنوعی بهواسطه آنها قادر است ارتباطات علمی و انتشار مقالات را متحول کند. ناشران علمی در حال حاضر از هوش مصنوعی مولد برای آزمایش ابزارهای جستوجوی علمی، ویرایش و خلاصهسازی سریع مقالات استفاده میکنند. بسیاری از محققان تصور میکنند که غیرانگلیسیزبانان میتوانند بیشترین بهره را از این ابزارها ببرند. برخی نیز هوش مصنوعی مولد را راهی برای دانشمندان میدانند تا درباره چگونگی تحقیق و خلاصه کردن نتایج تجربی فکر کنند. آنها قادرند از LLMبیشتر برای پیشبرد کار استفاده کنند؛ به این معنی که زمان کمتری برای نوشتن مقالات و زمان بیشتری برای انجام آزمایشها در اختیار داشته باشند. «مایکل آیزن»، زیستشناس محاسباتی در دانشگاه کایفرنیا که سردبیر مجله eLife است، میگوید: «هدف هیچ کسی صرفا نوشتن مقاله نیست بلکه تولید و پیشبرد علم است.» او پیشبینی میکند که ابزارهای مولد هوش مصنوعی حتی قادرند ماهیت مقالات علمی را بهطور اساسی تغییر دهند. مدل LLMصرفا موتورهایی برای تولید خروجی مقالاتی است که نه برای تولید اطلاعات دقیق بلکه متناسب با الگوهای ورودی آنها عمل میکنند. ناشران نگران این هستند که افزایش استفاده از این مدلها و نرمافزارهای هوش مصنوعی ممکن است منجر به تولید تعداد بیشتری از نسخههای دستنویس بیکیفیت و پرخطا شود و به این واسطه احتمالا سیلی از مقالات جعلی به کمک هوش مصنوعی شناسایی میشوند که این امر نگرانیهایی را به دنبال داشته است.

نگرانی ناشران از سیل مقالات جعلی

ناشران علمی و سایر محققان نسبت به تاثیر بالقوه هوش مصنوعی مولد ابراز نگرانی کردهاند. «دانیل هوک» مدیر اجرایی علوم دیجیتال یک شرکت پژوهشی تحلیلی در لندن میگوید: «دسترسی به ابزارهای هوش مصنوعی مولد میتواند تولید مقالات بیکیفیت را آسانتر کرده و در بدترین حالت، یکپارچگی پژوهشها را به خطر بیندازد.» در بعضی موارد، محققان اعتراف کردهاند که از نرمافزار ChatGPT برای کمک به نوشتن مقالات استفاده کرده و این راز را برملا نکردهاند اما نشانههایی که در داخل متن مبنیبر استفاده از این نرمافزار وجود داشته باعث شده دستشان رو شود. ازجمله مواردی که نشان میدهد محققان از این نرمافزار استفاده کردهاند میتوان به استفاده از منابع جعلی یا پاسخهای برنامهریزیشده نرمافزاری اشاره کرد که نوعی مدل زبانی هوش مصنوعی به شمار میروند. در حالت ایدهآل، ناشران میتوانند متن گزارش تولیدشده توسط مدل LLM را تشخیص دهند. عملا ابزارهای تشخیص هوش مصنوعی تاکنون نتوانستهاند چنین متنی را انتخاب کرده و در عین حال از علامتگذاری متن نوشتهشده توسط انسان بهعنوان محصول هوش مصنوعی اجتناب میکنند. اگرچه توسعهدهندگان مدل LLM تجاری در حال کار روی مقالات خروجی تولیدشده توسط LLM هستند تا آنها را نشاندار کنند، هیچ شرکتی هنوز این کار را عهدهدار نشده است. «ساندرا واچر» محقق حقوقی دانشگاه آکسفورد که بر مفاهیم اخلاقی و قانونی فناوریهای نوظهور تمرکز دارد معتقد است هرگونه واترمارکی نیز قابل حذف شدن است. او ابراز امیدواری کرده است که قانونگذاران در سراسر جهان تلاش میکنند واترمارکها را با کمک LLM حذف کرده و استفاده از آنها را غیرقانونی اعلام کنند. ناشران یا با ممنوع کردن استفاده از مدل LLM بهطور کامل به این موضوع نزدیک میشوند یا در بیشتر موارد بر شفافیت اصرار دارند. تحقیقی که حدود 100 ناشر و مجله در آن مورد بررسی قرار گرفته، نشان میدهد که تا ماه می2023، حدود 17 درصد ناشران و 70 درصد از مجلات، دستورالعملهایی را درمورد چگونگی استفاده از هوش مصنوعی مولد منتشر کردهاند؛ این درحالی است که چگونگی استفاده از ابزارهای هوش مصنوعی در آنها متفاوت بوده است. بسیاری از ویراستاران نسبت به این موضوع ابراز نگرانی کردهاند که هوش مصنوعی مولد برای تولید آسانتر مقالات جعلی مورد استفاده قرار گیرد. شرکتهایی که گزارشهای دستنویس یا موقعیتهای تالیفی را به محققانی میفروشند که به دنبال تقویت خروجی مقالات منتشرشده هستند، به کارخانههای تولید کاغذ شناخته میشوند و میتوانند از این جهت سود زیادی به جیب بزنند. کارشناسان بر این باورند که استفاده از مدلهای LLM مانند ChatGPT میتواند مشکل کارخانههای تولید کاغذ را تشدید کند. یکی از واکنشهایی که نسبت به این نگرانیها عنوان شده این است که برخی مجلات رویکردهای خود را تقویت میکنند تا اذعان کنند که نویسندگان آنها واقعی بوده و از نرمافزارهای هوش مصنوعی برای نوشتن مقالات بهره نمیگیرند. رئیس انتشارات علمی «امبو پرس» در «هایدلبرگ» آلمان معتقد است که نویسندگان باید تنها از ایمیلهای سازمانی قابل تایید برای ارسال مقالات استفاده کرده و کارکنان تحریریه با نویسندگان و داوران در تماسهای ویدئویی ملاقات داشته باشند. او همچنین اضافه میکند که موسسات پژوهشی و سرمایهگذاران نیز باید بر خروجی کارکنان خود نظارت کرده و دریافتکنندگان کمک مالی را بهدقت مورد بررسی قرار دهند.

کمک به محققان غیرانگلیسیزبان در نوشتن مقاله

مجله nature بانظرسنجی از محققان پیرامون مزیت هوش مصنوعی مولد برای علم به این نکته اشاره میکند که بیشتر محققان بر این امر تاکید داشتهاند که استفاده از هوش مصنوعی مولد به محققانی که زبان اصلی آنها انگلیسی نیست، در نوشتن مقالات کمک میکند. به گفته «تاتسویا آمانو» دانشمند محیطزیست دانشگاه کوئینزلند در استرالیا، استفاده از ابزارهای هوش مصنوعی میتواند برابری در علم را بهبود بخشد. او به همراه همکارانش، بیش از 900 دانشمند محیطزیست را که حداقل یک مقاله به زبان انگلیسی نوشته بودند، مورد بررسی قرار دادند. در میان محققان اولیه، آن دسته از محققانی که زبان آنها غیر انگلیسی بود، اعلام کردند که مقالات آنها به دلیل مسائل نوشتاری، دو برابر بیشتر از محققان انگلیسی زبان بومی مردود شده است. آنها همچنین عنوان کردهاند که زمان کمتری را صرف نوشتن مقالات ارسالی کردهاند. به گفته آنها، استفاده از نرمافزارهای هوش مصنوعی کمک زیادی به این قبیل محققان در نوشتن مقالات به زبان انگلیسی میکند.

آمانو که به زبان مادری ژاپنی سخن میگوید، با آزمایشی که روی نرمافزار ChatGPT انجام داده، میگوید فرآیند استفاده از آن مشابه کار با همکاری است که به زبان مادری انگلیسی حرف میزند؛ اگرچه استفاده از چنین ابزارهایی گاه با خطاهایی همراه است. او در ماه مارس به دنبال ممنوعیت ابزارهای هوش مصنوعی مولد توسط مجلات، سرمقالهای را در مجله science منتشر و استدلال کرد تا زمانی که نویسندگان استفاده از این نرمافزار را در مقاله نویسیهای خود به وضوح عنوان میکنند، میتوان انتشار مقالات علمی را عادلانه و منصفانه دانست.

جایگزین جامعی برای نرمافزارهای قبلی

مدل LLM با نخستین نرمافزاری که به کمک هوش مصنوعی مولد توانست مقالهنویسی را برای محققان تسهیل کند، فاصله زیادی دارد. یکی از محققان هوش مصنوعی دانشگاه توکیو میگوید هوش مصنوعی مولد انعطافپذیری بالایی دارد. او عنوان میکند که پیشتر از نرمافزار Grammarly برای بهبود گرامر و املای مقالات انگلیسی خود استفاده میکرد که بر پایه هوش مصنوعی عمل میکرد. اما با روی کار آمدن نرمافزار ChatGPT و جایگزین شدنش با نرمافزارهای قبلی، محققان عنوان کردند این نرمافزار هوش مصنوعی مولد کارایی جامعتری نسبت به نمونههای قبلی داشته و در درازمدت ارزش بهتری پیدا میکند. درواقع، با استفاده از این نرمافزار، به جای پرداخت و خرید چند ابزار، میتوان تنها از یکی از ابزار نرمافزاری جامع استفاده کرد که نهتنها در هزینه بلکه در زمان هم صرفهجویی میکند.

محققان در بررسی نرمافزارها و مدلهای هوش مصنوعی مولد عنوان کردهاند که شیوه توسعه مدل LLM ممکن است نابرابریها را تشدید کند. آنها ابراز نگرانی کردهاند که برخی LLMهای رایگان ممکن است در آینده برای پوشش هزینههای توسعه و اجرای آنها با قیمت بالایی در اختیار کاربران قرار گیرد. از سوی دیگر، اگر ناشران از ابزارهای تشخیص مبتنیبر هوش مصنوعی استفاده کنند، به احتمال زیاد مقالات نوشتهشده توسط محققان انگلیسیزبان غیربومی را به اشتباه بهعنوان هوش مصنوعی علامتگذاری کنند. بررسیها نشان میدهد که این اتفاق در نسل فعلی آشکارسازهای GPT رخ میدهد.

چالشهای یک داوری دقیق

مدلهای LLM در فرآیند داوریهای دقیق یک موهبت به شمار میروند. برخی محققان اشاره کردهاند که از زمان استفاده از ChatGPTپلاس بهعنوان دستیار، توانستهاند بازبینی بیشتری را بپذیرند و از LLM برای پرداختن به نظرات استفاده کنند. آنها تاکید میکنند که با کمک این ابزارها به جای صرف چند روز برای اصلاح یک مقاله، تنها چند ساعت صرف میکنند. شاید استفاده از این ابزار چالشهایی هم به همراه داشته باشد اما پذیرفتن اینکه این ابزارها هم بخشی از فرآیند تحقیقاتی شده است، اجتنابناپذیر است. محقق دیگری از دانشگاه «فردریش شیلر» آلمان، از مزایای این نرمافزار برای تولید خلاصههای سریع برای پیش چاپهای در حال بررسی، یاد کرده است. یکی از نگرانیهای اصلی این است که محققان میتوانند با کمی تفکر بر ChatGPT تکیه کنند، هرچند محققان بر این باورند که درخواست مستقیم از مدل LLM برای بازبینی یک مقاله دستنویس ارزشی فراتر از خلاصهها و پیشنهادهای ویراستاری انتشار دارد.

برخی ناشران علمی از جمله تیلور و فرانسیس، الزیویر و IOP، محققان را از آپلود نسخههای دستنویس و بخشهایی از متن مقالات در پلتفرمهای هوش مصنوعی مولد برای تهیه گزارشهای دقیق منع کردهاند. موسسه ملی بهداشت آمریکا در ماه ژوئن استفاده از ChatGPT و سایر ابزارهای هوش مصنوعی مولد را برای نقد و بررسی دقیق کمکهای مالی ممنوع اعلام کرد. دو هفته بعد، شورای تحقیقات استرالیا پس از اینکه بررسی استفاده از ChatGPT در برخی مقالات بهطور آنلاین مشخص شد، استفاده از هوش مصنوعی مولد را در طول فرآیند بررسی کمکهزینهها به همین دلیل ممنوع اعلام کرد. یکی از راههای دور زدن این ممنوعیتها، استفاده محرمانه و خصوصی از LLMهای میزبان است. باوجوداین، میتوان مطمئن بود که دادهها به شرکتهایی که میزبان LLMها در فضای ابری هستند، بازخورد داده نمیشود. یکی از محققان عنوان کرده است که اگر چگونگی ذخیره LLMها و چگونگی حفاظت و استفاده از دادههایی که در آنها به کار میرود، مشخصتر بود، میتوان این ابزارها را در سیستمهای بازبینی ادغام کرد که ناشران پیشتر به کار برده بودند. اگر از این ابزارها به درستی استفاده شود، فرصتهای واقعی ایجاد خواهد شد. ناشران بیش از نیم دهه است که از ابزارهای هوش مصنوعی یادگیری ماشینی و پردازش زبان طبیعی برای کمک به داوری دقیق مقالات استفاده میکنند و هوش مصنوعی مولد میتواند قابلیت این نرمافزارها را افزایش دهد.

مهارتهای بیانی را تضعیف میکند

برخی محققان این گونه استدلال میکنند که LLMها از نظر اخلاقی وضعیت مبهمی دارند و نمیتوانند در فرآیند انتشار مقالات علمی گنجانده شوند. یکی از دانشمندان علوم شناختی در دانشگاه «رادبورد» هلند معتقد است که نگرانی اصلی در چگونگی کار با LLM نهفته است. از دیدگاه او، هوش مصنوعی مولد، یک سرقت ادبی خودکار از نظر طراحی است چراکه کاربران هیچ ایدهای ندارند که چنین ابزارهایی، دادههای خود را از کجا تامین میکنند و تنها مصرفکننده هستند. او بیان کرده که اگر محققان از این مشکل بیشتر مطلع باشند، تمایلی به استفاده از ابزارهای هوش مصنوعی نمیکنند. برخی پیشنهاد دادهاند که آموزش LLM در حوزههای علمی در رشتههای خاص میتواند یکی از راههای بهبود دقت و ارتباط خروجی آنها برای دانشمندان باشد. البته در این میان، نگرانی دیگری هم مطرح شده است مبنیبر اینکه وابستگی زیاد محققان به مدل LLM ممکن است در درازمدت مهارتهای بیان آنها را ضعیفتر کند. محققان در مراحل اولیه ممکن است مهارتهای لازم برای انجام بررسیهای منصفانه را از دست بدهند.

تغییرات در انتشار مقالات و پژوهشها

یکی از دانشمندان ارشد یادگیری ماشینی که در یکی از موسسات هوش مصنوعی در مونترال کانادا فعالیت میکند، میگوید ابزارهای هوش مصنوعی مولد این پتانسیل را دارند که نحوه انتشار پژوهشها را دگرگون کنند. این میتواند به این معنی باشد که تحقیقات بهگونهای منتشر میشوند که به راحتی توسط ماشینها قابل خواندن باشند تا انسان. در عصر LLM، این محقق آیندهای را به تصویر میکشد که در آن یافتهها در قالب تعاملی، نه بهعنوان یک محصول ثابت و یک اندازه برای همه منتشر میشوند. در این مدل، کاربران میتوانند از یک ابزار هوش مصنوعی برای یافتن پاسخ سوالات مربوط به آزمایشها، دادهها و تجزیه و تحلیلها استفاده کنند که به آنها اجازه میدهد جنبههای یک تحقیق را مورد بررسی قرار دهند. شرکتهایی چون «الیسیت» و scite پیشتر هم ابزارهای جستوجو را راهاندازی کردهاند که در آنها از LLM برای ارائه پاسخ به محققان در قالب زبان طبیعی استفاده میکنند. در ماه آگوست، الزیویر نسخه آزمایشی ابزار خود یعنی Scopus AI را برای ارائه خلاصهای سریع از موضوعات تحقیقاتی راهاندازی کرد. بهطورکلی، این ابزارها از LLM برای بازنویسی نتایجی حاصل از عبارتهای جستوجوی معمولی استفاده میکنند. درواقع، ابزارهای هوش مصنوعی مولد قادرند چگونگی انجام آنالیزها و بررسیهای محققان را تغییر دهند.