ندا اظهری، مترجم: گسترش فناوریهای نوظهور و پیشرفت جوانب مختلف هوش مصنوعی در سالهای اخیر آن را به فراگیرترین فناوری جدید ساخت بشر تبدیل کرده است. فناوری که استفاده از آن برخلاف دورهها و سالهای قبل منحصر به شرکتها و مجموعههای اقتصادی نمانده و به سرعت در حال گسترش بین کاربران عادی است. همین امر هم باعث شده در بسیاری از مراکز از جمله دانشگاهها و مراکز آموزشی و در قالب فعالیتهای درسی و پژوهشی نیز به طور گسترده مورد استفاده قرار گیرد. اما در این میان، استفاده از هوش مصنوعی در فضاهای دانشگاهی نیازمند حفظ چهارچوبهایی است که مراکز علمی مطرح دنیا به ویژه در دو سه سال اخیر تلاش کردهاند همراه با موج گسترش آن، ضوابط و شرایط ویژه آن را تدوین کنند. در ایران تاکنون تنها دانشگاهی که دستورالعمل مشخصی را برای بهرهمندی از فناوری هوش مصنوعی اعلام کرده، دانشگاه صنعتی شریف است در حالی که در آمریکا قریببه 116 دانشگاه تاکنون به این مسئله پرداخته و شیوهنامه و چهارچوب مشخصی را برای استفاده مخاطبان مختلف نظیر دانشجویان یا استادان در نظر گرفتهاند. «فرهیختگان» در ادامه، ضمن بررسی اسناد و دستورالعملهای دانشگاههای آمریکایی در حوزه هوش مصنوعی، مروری هم بر چهارچوبها و دستورالعملهای ارائه شده از سوی سه دانشگاه برتر آمریکا داشته است.

دانشگاهها و هوش مصنوعی؛ سیاستها و قوانین

پس از انتشار عمومی ChatGPT، ابزارهای هوش مصنوعی مولد (GenAI) به طور گستردهای در بخشهای مختلف از جمله آموزش عالی مورد استفاده قرار گرفتهاند. در ابتدا ChatGPT واکنشهای متفاوتی را برانگیخت. گزارشهای اولیه در مورد واکنش مؤسسات آموزش عالی به GenAI طیف وسیعی از واکنشها را به دنبال داشت. برخی از دانشگاهها استفاده از ابزارهای هوش مصنوعی مولد را ممنوع کردند در حالی که برخی دیگر کاملاً آن را پذیرفتند و استفاده از آنها را برای آموزش و یادگیری مجاز دانستند. در حال حاضر شمار زیادی از دانشجویان و استادان از این فناوری بهرهمند میشوند و به نظر نمیرسد ممنوعیت استفاده از آن راهحل عملی باشد. بررسیها نشان میدهد تقریباً نیمی از دانشجویان دانشگاه کمبریج به استفاده از ChatGPT در طول تحصیل خود اذعان کردهاند. مجله فوربس گزارش داده که 20 درصد از دانشجویان کالجهای آمریکا از هوش مصنوعی برای تکمیل تکالیف خود استفاده میکنند. پذیرش سریع هوش مصنوعی مولد توسط دانشجویان در آموزش عالی، درخواستها برای دستورالعملها و سیاستهایی برای کاربرد آن در آموزش عالی در دنیا را شدت داده است. مطالعه روی 50 دانشگاه برتر آمریکا، رویکردی ترکیبی متشکل از مدلسازی موضوعی، تحلیل احساسات و تحلیل موضوعی کیفی، درک زمینهای و چند وجهیتری از دستورالعملهای سازمانی را درمورد استفاده از هوش مصنوعی مولد در فعالیتهای دانشگاهی و اداری ارائه میدهد. این مطالعه در قالب یک مقاله علمی به تازگی در مجله بینالمللی فناوری آموزشی در آموزش عالی منتشر شده است.

مزیتهای بهرهمندی از هوش مصنوعی مولد

بررسیها نشان میدهد هوش مصنوعی مولد میتواند یادگیری شخصی و انطباقی را تسهیل کرده، راهنمایی و پشتیبانی شخصی را ارائه کند و بازخوردی فوری ارائه داده و ارتباطات و همکاریها را تسهیل کند. درواقع، GenAI میتواند طیف وسیعی از نقشها را در فرایندهای آموزشی و یادگیری ایفا کند. یونسکو پیشنهاد کرده است ChatGPT میتواند به عنوان یک رقیب، مربی مشارکتی و آموزگار شخصی در میان نقشهای دیگر مورد استفاده قرار گیرد. اما محققان هشدار دادهاند که مزایای این فناوری تنها زمانی قابل دستیابی است که به طور مؤثر از آن استفاده شود. بسیاری از موضوعات در مورد استفاده از فناوریهای هوش مصنوعی و هوش مصنوعی مولد به نگرانی از تقلب و سرقت ادبی در تکالیف یا امتحانات کتبی به ارسال محتوای تولید شده توسط هوش مصنوعی برمیگردد. انتشار ChatGPT به سرعت با توسعه ابزارهای تشخیص محتوای هوش مصنوعی مانند GPTZero، ZeroGPT و Winston AI دنبال شد. محققان استدلال کردهاند دانشجویان میتوانند بیش از حد به GenAI وابسته شوند و به طور بالقوه بر مهارتهای نوشتاری و تفکر انتقادی آنها تأثیر منفی بگذارد. همچنین نگرانیهایی در مورد دسترسی نابرابر به ابزارهای GenAI، حریم خصوصی دانشجویان و امنیت دادهها، سوگیریها در الگوریتمهای هوش مصنوعی و انتشار اطلاعات جعلی تولید شده توسط هوش مصنوعی وجود دارد.

سیاستهای موردنیاز برای مؤسسات آموزش عالی

افزایش پذیرش GenAI تأثیر مخربی بر رویههای ارزیابی در آموزش عالی دنیا داشته است و ماهیت مخرب این فناوری، فشار زیادی را به دانشگاهها وارد میکند تا سیاستها و دستورالعملهایی را در واکنش به این فناوری ایجاد کنند. اگرچه بسیاری از دستورالعملهای مرتبط با هوش مصنوعی پیش از ChatGPT منتشر شده بودند، بیشتر آنها به طور خاص به مسائل و چالشهای ناشی از هوش مصنوعی مولد در آموزش عالی نمیپردازند. ببیشتر مؤسسات فاقد دستورالعملهای تخصصی برای استفاده اخلاقی از GenAI بوده و سیاستهای موجود اغلب مسائل مهمی مانند حریم خصوصی دانشجویان را نادیده میگیرند. بسیاری از سازمانهای بینالمللی مانند سازمان آموزشی، علم و فرهنگی ملل متحد و سازمان همکاری اقتصادی و توسعه، دستورالعملهایی را در مورد استفاده از GenAI در آموزش منتشر کردهاند. باوجوداین، این دستورالعملها به جای مشکلات خاصی که آموزش عالی با آن مواجه است، بر مسائل گستردهتر مرتبط با تأثیر این فناوری متمرکز است. فقدان دستورالعملها و خط مشیهای روشن در مورد GenAI بر مشکلات دانشگاهها برای رسیدگی مؤثر به چالشهای مرتبط با GenAI میافزاید.

نتایج نشان داده است دستورالعمل ارزشیابی، سه حوزه اصلی شامل یکپارچگی تحصیلی، طراحی آزمون و برقراری ارتباط با دانشجویان را پوشش میدهد. اسناد دستورالعملهای ارائه شده از سوی 116 دانشگاه آمریکایی نشان میدهند بیش از 60 درصد از دانشگاهها، دانشجویان را به استفاده از هوش مصنوعی مولد ترغیب میکنند و حدود 40 درصد از آنها نیز راهنماییهای دقیقی را برای استفاده از آن در کلاس درس ارائه میدهند. بیش از نیمی از مؤسسات (56 درصد) برنامههای درسی نمونه و 50 درصد نمونه فعالیتهای GenAI را ارائه کردند که به مربیان کمک میکند این فناوری را در کلاسهای درسی خود ادغام کنند.

انجام مطالعه بر پایه چهار گام

مطالعه اسناد مربوط به هوش مصنوعی دانشگاههای آمریکا براساس چهار گام شامل جمعآوری داده؛ مدلسازی موضوعی؛ تحلیل احساسات و تحلیل کیفی موضوعی صورت گرفته است. محققان در گام نخست، دستورالعملهای هوش مصنوعی مولد را از دانشگاههای منتخب (50 دانشگاه برتر) به طور سیستماتیک جمعآوری کردهاند. در گام دوم که مدلسازی موضوعی است، از استخراج ویژگی و بهینهسازی «تخصیص پنهان دیریکله»(LDA) (یک مدل تولیدی در آمار) برای شناسایی موضوعات اصلی استفاده شده است. این مرحله بر تمیز کردن کامل اسناد با حذف کاراکترهای غیرضروری و استاندارد کردن قالبهای متن متمرکز است. در گام بعدی یعنی تحلیل احساسات، محققان به تجزیه و تحلیل احساسات برای بررسی روندهای احساسات و ارتباط بین تحلیل احساسات و حوزههای موضوعی پرداختهاند. تحلیلگر، شدت احساسات یک امتیاز ترکیبی را محاسبه میکند که احساسات کلی بیان شده در یک متن را با هم ادغام میکند که شامل 1- (نشان دهنده یک احساس بسیار منفی) تا 1+ (نشاندهنده خلق و خوی بسیار مثبت) است. با این نمرات، مقایسهای از تفاوت در بیان احساسی در اسناد انتخاب شده صورت گرفته است. در گام چهارم که تحلیل کیفی موضوعی است، پس از تکمیل تجزیه و تحلیل «تخصیص پنهان دیریکله»، دستورالعملهای GenAI بیشتر مورد تجزیه و تحلیل قرار گرفته تا درک دقیقتر و زمینهای به دست آید. سپس دو محقق، زیرمجموعهای از دستورالعملها را به صورت جداگانه کدنویسی کردند و سپس موضوعات شناسایی شده را مقایسه و بحث کردند تا به یک اجماع برسند. با دنبال کردن انسجام نمرات، محققان چهار موضوع را شناسایی کردند. این نمرات برای ارزیابی کیفیت موضوعی در مدلهایی مانند LDA اهمیت دارند که در آن، نمرات با انسجام بالا نشاندهنده ارتباط معنایی قوی بین کلمات در یک موضوع است و معنیدار بودن و قابلیت تفسیر آن را افزایش میدهد. از سوی دیگر، استفاده از مقیاسبندی چندبعدی، روابط بین موضوعات شناسایی شده را به صورت بصری نشان میدهد. نزدیکی دایرهها بیانگر میزان ارتباط بین موضوعاتی است که آنها نشان میدهند. الگوریتم LDA به هر موضوع برچسبهای عددی اختصاص داده است.

دستورالعملهای GenAI دانشگاههای برتر به چه موضوعاتی پرداختند؟

در دستورالعملهای GenAI که در 50 دانشگاه برتر آمریکا مورد استفاده قرار گرفته، چهار موضوع اصلی مطرح شده است. موضوع اول یعنی ادغام هوش مصنوعی مولد در یادگیری و ارزیابی که 30 درصد از علائم را نشان میدهد، بیانگر غالبترین موضوع در دادههاست. موضوع دوم، هوش مصنوعی مولد در رسانههای بصری، تعاملی و چندرسانهای و موضوع سوم، ملاحظات اخلاقی و امنیتی در هوش مصنوعی مولد که به ترتیب 28.8 درصد و 21.3 درصد از نشانهها را دربرمیگیرد و در مقایسه با موضوع اول، کمتر غالب هستند. موضوع چهارم هم هوش مصنوعی در یکپارچگی آکادمیک است که شامل 20 درصد از نشانههاست.

7 نکته کلیدی برای اعضای هیئت علمی دانشگاهها

تقریباً تمام دانشگاهها (47 دانشگاه از جمع 50 دانشگاه) دستورالعملهایی را برای استفاده از هوش مصنوعی مولد به اعضای هیئت علمی خود ارائه کردهاند. 7 موضوع اصلی در این دستورالعملها مطرح شده است.

1. بیانیههای برنامه درسی برای استفاده GenAI:

بیش از نیمی از دانشگاهها (56 درصد) راهنماییهایی را درباره بیانیههای برنامه درسی در مورد استفاده از ابزار GenAI ارائه کردند. به عنوان مثال، دانشگاه استنفورد بیانیههای برنامه درسی الگو را برای استفاده GenAI در سه دسته ابزارهای هوش مصنوعی که آزادانه مجاز به استفاده هستند؛ استفاده از هوش مصنوعی مجاز با محدودیت و عدم استفاده از هوش مصنوعی مجاز، ارائه کرد. همچنین دانشگاه شیکاگو نمونههایی از بیانیههای برنامه درسی را در مورد استفاده از ابزارهای هوش مصنوعی در چهار گروه، ممنوعیت استفاده در تمام موقعیتها؛ استفاده با مجوز قبلی؛ استفاده با استنادهای مناسب و استفاده رایگان بدون نیاز به استناد ارائه کرده است.

۲. تنظیم و ابلاغ خط مشی استفاده از GenAI :

۲۷ دانشگاه (54 درصد) به اعضای هیئت علمی خود توصیه کردهاند سیاستهای خود را در رابطه با هوش مصنوعی مولد تنظیم کرده و این خط مشی را به دانشجویان خود ابلاغ کنند. آنها بر اهمیت ارتباط واضح انتظارات در مورد آنچه در مورد استفاده از هوش مصنوعی مجاز است و چه چیزی مجاز نیست، تأکید و اشاره کردند که بسیاری از دانشجویان بدون دستورالعملهای روشن از سوی استادان خود از هوش مصنوعی استفاده میکنند.

۳. طراحی مجدد تکالیف و آزمونها: کمتر از نیمی از دانشگاهها (48 درصد) به اعضای هیئت علمی خود توصیه کردهاند تکالیف و آزمونهای درسی را دوباره طراحی کنند. ارزیابیهای معتبری چون انجام پروژهها، آزمونهای فرایندمحور مانند پیشنویسها، ارائهها، امتحانات شفاهی و نمونه کارها و تکالیفی که نیاز به تفکر دارند معمولاً در تنظیم تکالیف و آزمونها در عصر GenAI توصیه میشوند. علاوه براین، سواد هوش مصنوعی و استناد به هوش مصنوعی مولد در دستورالعملها مورد توجه قرار گرفته است.

۴. تعریف و تبیین هوش مصنوعی مولد: 21 دانشگاه (42 درصد) اطلاعات اولیه درباره GenAI، ازجمله GenAI و مفاهیم مرتبط، قابلیتها و محدودیتهای آن، تأثیر آن بر آموزش عالی و نمونههایی از ابزار هوش مصنوعی مولد را به اعضای هیئت علمی ارائه دادهاند.

۵. پرهیز استفاده از ابزارهای تشخیصی: با توجه به محدودیتهای ابزارهای فعلی تشخیص هوش مصنوعی، 19 دانشگاه (38 درصد) اظهار داشتند استفاده از این ابزارهای تشخیص را توصیه نمیکنند. برخی دانشگاهها حتی «تورنیتین» به عنوان یک سرویس تشخیص شباهت مبتنی بر اینترنت را نیز غیرفعال کردند.

۶. گنجاندن GenAI در تدریس: 16 دانشگاه (32 درصد) دستورالعملها و توصیههایی را برای گنجاندن GenAI در تدریس به هیئت علمی خود ارائه کردند. به عنوان مثال، دانشگاه کارولینای شمالی اصولی را برای استفاده از این فناوری در تدریس ارائه کرده است مانند اینکه هوش مصنوعی باید به شما در آموزش کمک کند نه اینکه به جای شما تدریس کند. طبق این دستورالعمل، اعضای هیئت علمی 100 درصد مسئول مطالب آموزشی خود هستند، تفکر انتقادی را تسهیل کرده و اطمینان حاصل میکنند که استفاده از هوش مصنوعی فراگیر است.

۷.استفاده اخلاقی از GenAI :

۱۲دانشگاه (24 درصد) بر اهمیت حفظ حریم خصوصی دادهها تأکید کرده و راهبردهایی را در مورد استفاده اخلاقی از این فناوری ارائه کردند.

پیشنهادهای عمومی برای استفاده دانشگاهیان از GenAI

حدود 70 درصد از دانشگاهها (34 دانشگاه از جمع 50 دانشگاه برتر) دستورالعملهایی را برای تمام ذینفعان بدون اختصاص به یک گروه خاص ارائه دادهاند. پنج موضوع اصلی برای دستورالعملها مشخص شده است.

۱. حریم خصوصی و امنیت: نیمی از دانشگاهها (50 درصد) دستورالعملهایی داشتند که نگرانیهای مربوط به حریم خصوص و امنیت را مشخص میکنند. به طور خاص، دانشگاهها بر اهمیت حفاظت از اطلاعات شخصی و خصوصی تأکید کرده و دستورالعملهایی را برای حفاظت از دادهها هنگام استفاده از ابزارهای GenAI ارائه کردند.

۲. محدودیتها و خطر GenAI: با تأکید بر محدودیتها و خطرات GenAI مانند محتوای نادرست، سوگیریها و غیره، 19 دانشگاه (38 درصد) جامعه را تشویق کردهاند تا خروجیهای ابزار GenAI را به دقت بررسی کنند. دانشگاهها همچنین در مورد کلیشههای بازتولید شده توسط این ابزارها هشدار دادهاند.

۳. GenAI چیست: 14 دانشگاه (28 درصد) تعاریف هوش مصنوعی مولد و اصطلاحات مرتبط را در دستورالعملهای خود برای تمام ذینفعان ارائه کردند. آنها یک نمای کلی از GenAI را معرفی کردند ازجمله ابزارهای فهرست شده میتوان به ChatGPT، Gemini گوگل، Copilot مایکروسافت و هوش مصنوعی Zoom اشاره کرد.

۴. یکپارچگی دانشگاهی: 13 دانشگاه (26 درصد) شامل اطلاعات خط مشی یا دستورالعملهایی در مورد یکپارچگی دانشگاهی بودند. به عنوان مثال، دانشگاه شیکاگو به صراحت توضیح داده است اگر منبع اطلاعات فاش نشود، استفاده از اطلاعات به دست آمده از یک منبع خارجی سرقت ادبی محسوب میشود.

5. افشا و شفافیت: 11 دانشگاه (22 درصد) بر اهمیت شفافیت و افشای اطلاعات تأکید و به کاربران توصیه کردند استفاده از ابزارهای هوش مصنوعی را در میان بگذارند و مشخص کنند از کدام ابزار استفاده شده است. بحثها بر اهمیت افشا، استناد به ابزارهای هوش مصنوعی و اجتناب از سرقت ادبی متمرکز بوده است.

دستورالعملهای کلیدی برای دانشجویان

21 دانشگاه از 50 دانشگاه (42 درصد) دستورالعملهایی را برای دانشجویان در مورد استفاده از GenAI ارائه کردند. در این میان، سه موضوع اصلی از دستورالعملیهای دانشجویی شناسایی شده است.

1. یکپارچگی دانشگاهی: دستورالعملها برای دانشجویان 14 دانشگاه به خط مشی یکپارچگی تحصیلی و مسائل مرتبط، مانند پیامدهای سوءاستفاده از هوش مصنوعی و چگونگی استناد به هوش مصنوعی مولد پرداخته است.

2. بررسی با استادان: دستورالعملها برای دانشجویان 12 دانشگاه به طور مداوم توصیه میکند دانشجویان پیش از استفاده از ابزار GenAI برنامه درسی خود را مطالعه و با استادان خود مشورت کنند. از آنجایی که دورههای مختلف دارای خط مشیهای متفاوتی هستند، به دانشجویان توصیه میشود برای اطلاع از خط مشی دوره با استادان خود مشورت کرده و از راهنمایی آنها در مورد چگونگی استفاده از ابزار GenAI برای دوره یا تکالیف خود پیروی کنند.

3. محدودیتها و خطرات GenAI: دستورالعملها برای دانشجویان 9 دانشگاه بر اهمیت درک محدودیتها و خطرات GenAI تأکید کرده است. از آنجایی که خروجی مدلهای GenAI ممکن است نادرست، گمراهکننده، جانبدارانه و حتی ساختگی باشد، دستورالعملها به دانشجویان توصیه میکنند به طور انتقادی درباره GenAI فکر کرده و اطلاعات GenAI را به دقت ارزیابی، بررسی و راستیآزمایی کنند.

تعیین چهارچوب استفاده از GenAI برای محققان

9 دانشگاه از 50 دانشگاه (18 درصد) سه دستورالعمل کلی را برای محققان در مورد استفاده از GenAI در تحقیقات ارائه کردهاند.

1. محدودیتها و خطرات GenAI: پنج دستورالعمل از 9 دستورالعمل برای محققان، محدودیتهای خطرات GenAI مانند اطلاعات قدیمی، اطلاعات نادرست یا ساختگی، سوگیریها و خطرات حفظ حریم خصوصی را بیان میکنند و به محققان توصیه شده اطلاعات به دست آمده از GenAI را به طور انتقادی ارزیابی و تأیید کنند.

2. توصیههایی برای استفاده مسئولانه و اخلاقی از GenAI در پژوهشها: پنج دستورالعمل از 9 دستورالعمل برای محققان شامل توصیهها و بهترین شیوهها برای استفاده مسئولانه و اخلاقی از GenAI در تحقیقات ارائه شد.

3. به روز نگه داشتن دستورالعملها و کاربردهای GenAI: این دستورالعملها با تأکید بر اینکه ابزارها و دستورالعملهای هوش مصنوعی به طور مداوم در حال تغییرند، به محققان توصیه میکند در مورد ابزارهای نوظهور هوش مصنوعی آگاه باشند و به سیاستهای خاص مجلات و آژانسهای مالی در مورد استفاده از هوش مصنوعی پایبند باشند.

مدیران در مواجهه با GenAI چه کنند؟

7 دانشگاه از 50 دانشگاه برتر (14 درصد) دستورالعملهایی داشتند که به طور خاص کارکنان و مدیران را هدف قرار میداد.

1. حریم خصوصی و حفاظت از دادهها:

هر 7 دانشگاه درباره دستورالعملها و نگرانیهای مربوط به حفظ حریم خصوصی و دادهها بحث کردند. آنها به اعضای هیئت علمی و مدیران توصیه کردند که هیچ اطلاعات محرمانه یا حساسی را در ابزار GenAI وارد نکنند.

2. قابلیتهای هوش مصنوعی مولد:

6 دانشگاه از 7 دانشگاه، کاربردها و قابلیتهای GenAI را تشریح کرده و اعضای هیئت علمی و مدیران خود را تشویق کردند تا قابلیتهای فناوریهای جدید را کشف کنند.

3. محدودیتهای GenAI:

5 دانشگاه از 7 دانشگاه محدودیتهای هوش مصنوعی مولد را توصیف کردند که بیش از سایر محدودیتها روی نادرستی و سوگیری تمرکز داشت.

راهبردهای هوش مصنوعی در دانشگاه هاروارد

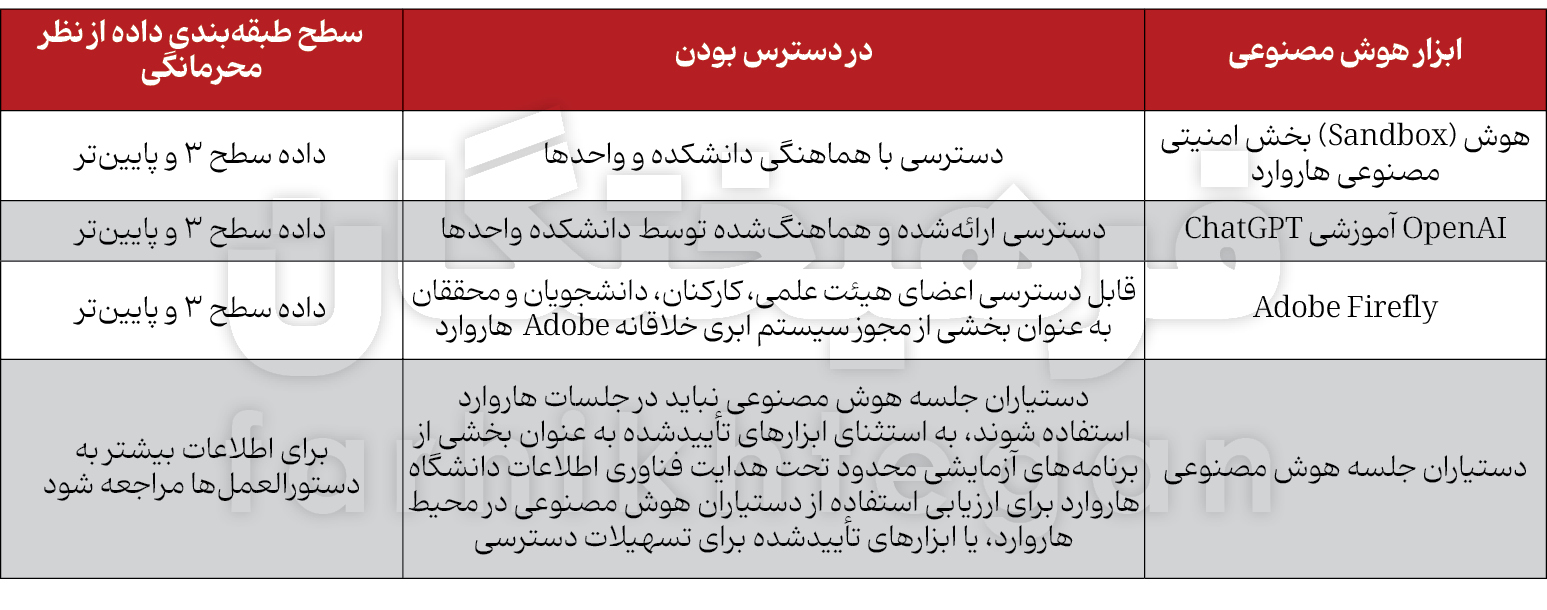

هوش مصنوعی مولد به عنوان یک فناوری به سرعت در حال تکامل است و از این رو، دانشگاههایی چون هاروارد دستورالعملهایی را برای استفاده از این فناوری مدنظر قرار دادهاند. این دانشگاه از سال 2023 مجموعهای از دستورالعملهای اولیه را برای امنیت اطلاعات و حریم خصوصی دادهها، کپیرایت و یکپارچگی آکادمیک در زمان استفاده از هوش مصنوعی مولد اعلام کرده است. محافظت از دادههای محرمانه یکی از این اصول است که مطابق با خطمشی امنیت اطلاعات دانشگاه، نباید دادههای طبقهبندیشده به عنوان محرمانه (سطح 2 و بالاتر)، از جمله دادههای پژوهشی غیرعمومی، را در ابزارهای هوش مصنوعی مولد در دسترس عموم وارد کرد. این دانشگاه در اطلاعیهای دیگر، طبقهبندی محرمانگی هاروارد برای استفاده از ابزارهای هوش مصنوعی را در جدولی حاوی ابزارها، معرفی آنها و سطح محرمانگی تشریح کرده است. اصل بعدی این است که افراد مسئول محتوای تولید یا منتشرشده و نیز مطالب تولیدشده توسط هوش مصنوعیاند. محتوای تولیدشده با هوش مصنوعی میتواند نادرست، گمراهکننده یا کاملاً ساختگی باشد یا حتی حاوی مطالب دارای حق نسخهبرداری باشد. سومین اصل، پایبند بودن به خطمشیهای فعلی در مورد یکپارچگی تحصیلی است. کتاب راهنما و خطمشیهای دانشجویی و استادی را مرور کنند. انتظار میرود دانشکدهها سیاستهای خود را توسعه داده و بهروزرسانی کنند. در این میان، استادان باید با دانشجویان خود شفاف بوده و در مورد سیاستها پیرامون استفادههای مجاز از هوش مصنوعی مولد در کلاسها و کارهای دانشگاهی مشورت کنند. چهارمین اصل، هوشیار بودن نسبت به فیشینگ مجهز به هوش مصنوعی است. هوش مصنوعی مولد، ایجاد کلاهبرداریهای پیچیده در مقیاس بزرگتر را برای عوامل مخرب آسانتر کرده است.پنجمین اصل، برقراری ارتباط با بخش فناوری اطلاعات دانشگاه هاروارد (HUIT) پیش از تهیه ابزارهای هوش مصنوعی مولد است. طبق این اصل، دانشگاه در تلاش است اطمینان حاصل کند ابزارهایی که از طرف هاروارد تهیه میشوند، از حریم خصوصی و حفاظتهای امنیتی مناسبی برخوردار بوده و بهترین استفاده را از بودجه این دانشگاه ارائه میکنند. علاوه بر این، دانشگاه هاروارد بخشی مخصوص را در سایت دانشگاهی خود به هوش مصنوعی اختصاص داده که شیوههای تدریس با هوش مصنوعی برای اعضای هیئت علمی، شیوههای یادگیری با این فناوری، پژوهش با کمک هوش مصنوعی و حتی کار کردن با این فناوری را آموزش داده است و کاربران میتوانند از آن استفاده کنند.

چشمانداز هوش مصنوعی در دانشگاه استنفورد

در سال 2024، رئیس دانشگاه استنفورد، هوش مصنوعی را در کمیته مشورتی استنفورد موظف کرد نقش هوش مصنوعی را در این دانشگاه در حوزه مدیریت، آموزش و پژوهش ارزیابی کند تا شکافهای سیاستی بالقوه و سایر نیازها را برای پیشبرد استفاده مسئولانه از هوش مصنوعی در استنفورد شناسایی کند. این کمیته، هفتبار بین ماههای مارس تا ژوئن برای ارزیابی شکافهای سیاستی بالقوه در زمینههای اداری، آموزشی و پژوهشی در استنفورد تشکیل جلسه داد. فرصتها و چالشهای بزرگی در ارتباط با جدیدترین نسل فناوریهای هوش مصنوعی بهویژه مدلهای زبانی بزرگ (LLM) وجود دارد. محققان به دلیل توانایی این فناوریها در تولید، پیشنویس، خلاصه کردن و تجزیهوتحلیل متن، تصاویر و سایر رسانهها، ابزارهای تحول آفرین قدرتمندی را برای بهرهوری بیشتر نشان میدهند. این فناوریها هم از نظر قابلیتها و هم در درجهای که میتوانند بازرسی، آزمایش و تأیید شوند، به سرعت در حال تکامل هستند.

استنفورد یکی از دانشگاههای پیشرو در توسعه و کاربرد هوش مصنوعی است و جامعه دانشگاهی آن شامل متخصصانی در ایجاد، اعتبارسنجی و گسترش قابلیتهای اصلی هوش مصنوعی است. در تمام دانشکدهها و واحدها، بسیاری از همکاران از هوش مصنوعی برای پیشبرد آموزش و تحقیق در رشتههای خود استفاده میکنند، بنابراین بیان مجموعهای اصلی از سیاستها، استانداردها و بهترین شیوهها برای استفاده از هوش مصنوعی در عملکردهای اداری، آموزشی و پژوهشی دانشگاه، عاقلانه به نظر میرسد. کمیته مشورتی استنفورد، رویکردهایی را توصیه میکند که انعطافپذیر بوده و استفاده خلاقانه از هوش مصنوعی را برای حمایت از مأموریتهای دانشگاهی محدود نمیکند، بلکه مجموعهای از اصول برای هدایت رویکرد به هوش مصنوعی را ارائه میدهد که باید به مدیریت موقت مسائل جدید کمک کنند.

اصول هوش مصنوعی در استنفورد

ارائه این اصول دانشگاه را ترغیب میکند اهداف را در این فضا مطابق با فلسفه مؤسسه هوش مصنوعی انسانمحور مشاهده کند تا اطمینان حاصل کند استفاده از این فناوری بر بهبود وضعیت انسان متمرکز است، بنابراین ترجیح آن است که تمرکز اصلی بر افزایش قابلیتهای انسانی- بهجای جایگزینی انسانها- گذاشته شود. بسیاری از محققان در استنفورد بهدنبال هدفی هستند که هوش مصنوعی بر جامعه تأثیر مثبت بگذارد. نظارت انسانی، یکی از اصولی که در این میان مطرح میشود. انسانها باید مسئولیت سیستمهای هوش مصنوعی مورداستفاده یا ایجادشده در استنفورد را برعهده گیرند. هدف هر سیستمی باید داشتن یک خط روشن از اختیارات و مسئولیتها برای تهیه و ایجاد سیستم، نگهداری و نظارت بر سیستم باشد.

اصل بعدی همسویی انسان است. سیستمهای هوش مصنوعی باید برای پشتیبانی از مأموریت و ارزشهای اصلی استنفورد مورد استفاده قرار گیرند. در صورت لزوم، سیستمها باید برای شناسایی خطرات و استراتژیهای کاهش، بهویژه برای اثرات منفی متفاوت، اتخاذ و مستقر شوند. دامنه استفاده، قابلیتهای سیستم و محدودیتهای سیستمها باید در یک فرایند مداوم مستند شده و بهطور منظم برای سازگاری با استانداردهای جامعه ارزیابی شوند. حرفهایگری انسانی نیز اصل دیگری است که مطرح میشود. اعضای جامعه استنفورد باید استانداردها را رعایت و دقت و کیفیت بالا را در کار خود لحاظ کنند. همچنین انتظار میرود بهترین قضاوتها و تفکرات انتقادی را در استفاده از ابزارهای هوش مصنوعی اعمال کنند. آنها در عین این که مسئول تبعیت از قوانین قابل اجرا و سیاستهای دانشگاهیاند، باید انتظارات و هنجارها را در جوامع حرفهای درنظر بگیرند. اصل دیگری که باید در هوش مصنوعی مورد توجه قرار گیرد، استفاده اخلاقی و ایمن از این فناوری است. هوش مصنوعی باید به منظور بهبود عملکرد دانشگاه به کار رود. تصمیمگیرندگان باید بهدنبال درک کامل استفاده از سیستمهای هوش مصنوعی در عملکرد دانشگاه باشند و زمانی که این مفاهیم بهطور کامل درک نشدهاند، باید ارزیابیها را آغاز کرد. اعضای جامعه دانشگاهی باید تلاش کنند خدمات هوش مصنوعی عدالت و استقلال فردی را ترویج کند و عاری از تبعیض غیرقانونی باشد.

اصل دیگر، حریم خصوصی، امنیت و محرمانه بودن است. زمانی که سیستمهای هوش مصنوعی از دادههای شخصی استفاده میکنند، قانونی بودن و تأثیر آن باید بهطور مناسب ارزیابی شود. ابزارهای مولد هوش مصنوعی اطلاعات وارد شده ازجمله اطلاعات محرمانه یا حساس را با شرکتهای وابسته خود ذخیره، استفاده مجدد و به اشتراک میگذارند. اصل بعدی، کنترل و کیفیت داده است. تمام دادههای مورد استفاده برای ایجاد سیستمهای هوش مصنوعی جدید با منابع دانشگاهی باید به روشهای قانونی و اخلاقی جمعآوری شوند و منشأ دادهها باید بهطور صریح مستند و بهعنوان بخشی از طراحی سیستم مدیریت شود. دانشگاه باید با ایجاد و حفظ زیرساخت دادهمحور، کلاس جهانی را درنظر بگیرد که برای استفاده از دادهها در هوش مصنوعی در چرخه عمر پژوهش برنامهریزی میکند. قانون طلایی هوش مصنوعی اصل دیگری است که استنفورد باید به آن بپردازد. درطول زمان تغییرات بزرگ در قابلیتها و کاربردهای هوش مصنوعی، استفاده از مقالات هوش مصنوعی یا به اشتراکگذاری آنها ممکن است مفید باشد. ارزیابیها در گذر زمان تغییر میکنند و براساس قضاوتهای فردی و هنجارهای درحال تکامل جامعه برای استفاده از هوش مصنوعی است.

هوش مصنوعی در فرایند اداری دانشگاه

کمیته مشورتی استنفورد حین بررسی کاربردها و فعالیتهای مرتبط با هوش مصنوعی در این دانشگاه، برخی حوزههای حیاتی را شناسایی کرده که ممکن است به حمایت بیشتر از سوی دانشگاه نیاز داشته باشند. یکی از فرایندهایی که هوش مصنوعی در دانشگاه به کار میآید، فرایند استخدام است. در این میان، نگرانیهایی در مورد سوگیری پیرامون استفاده از این فناوری برای بررسی، غربالگری یا فیلتر کردن متقاضیان شغلی و نیز تهیه شرح شغل و آگهیهای شغلی در دانشگاه وجود دارد. فرایند دوم، بررسی عملکرد است که در آن هوش مصنوعی میتواند کمککننده باشد. استفاده از این فناوری در تولید مواد بررسی عملکرد ممکن است مسائل مربوط به اعتماد و روحیه کارکنان را ایجاد کند، پس باید با دقت مدیریت شود. همچنین ممکن است در بررسی عملکرد، پیامدهای قانونی برای مواد تولیدشده توسط هوش مصنوعی وجود داشته باشد. پذیرش نیز سومین فرایند قابلاستفاده از این فناوری در دانشگاه استنفورد است. پذیرشهایی مانند استخدام، استفاده و تأثیر هوش مصنوعی در تصمیمگیریهای پذیرش و بررسی درخواستها در مقطع کارشناسی و کارشناسی ارشد، نگرانیهایی را در مورد سوگیری، خطر طرح دعوی قضایی و آسیب به شهرت ایجاد میکند. این کمیته توصیه میکند از هوش مصنوعی مولد در فرایند پذیرش بدون ارزیابی دقیق و مستند از عملکرد این سیستمها استفاده نشود.

ارتباطات فرایند دیگری است که کارکنان در نقشهای ارتباطی در سراسر دانشگاه ممکن است برای استفاده از هوش مصنوعی برای تولید محتوای دانشگاه به راهنمایی نیاز داشته باشند. نظارت نیز از دیگر فرایندها در کاربرد هوش مصنوعی در استنفورد بهشمار میرود. هرگونه جمعآوری داده در مورد فعالیتهای اعضای جامعه استنفورد، تهدیدی برای حریم خصوصی، محرمانه بودن، استقلال شخصی و اعتماد بین دانشگاه و اعضاست. اما در این بین، ملاحظات و توصیههایی نیز در مورد استفاده از هوش مصنوعی در فرایندهای دانشگاهی مطرح شده است. یکی از این ملاحظات، آموزش در مورد دادههای حساس است. امنیت دادهها و سیاستهای حفظ حریم خصوصی موجود برای منابع محاسباتی بسیاری از کاربردهای خدمات هوش مصنوعی را پوشش میدهد. توصیه و ملاحظه دیگر نیز دسترسی دانشگاه به مدلهای LLM است. مسائل مربوط به عدالت به دلیل گران بودن و دسترسی بین اعضای هیئت علمی، کارکنان، دانشجویان و کارآموزان، در دسترسی به مدلهای LLM وجود دارد. اگر LLM توسط دانشگاه ارائه شود، کمیته فرصتی را برای آموزش در مورد نحوه استفاده از آنها و مراقبت از مقالات ارائه میدهد.

کاربرد هوش مصنوعی در آموزش

در بخش حمایت از آموزش نیز حوزههایی ازجمله ارزیابی و نمرهگذاری در استفاده از هوش مصنوعی مطرح میشود. این کمیته خطرات بالقوهای را در به کارگیری نرمافزار هوش مصنوعی در فرایند نمرهدهی، ارزیابی، تشخیص سرقت ادبی یا ارائه بازخورد در مورد کار دانشجویان، ازجمله کیفیت، دقت، انصاف و سوگیری احتمالی عنوان میکند. کاربرد دیگر حمایتی نیز شامل استفاده دانشجویان از هوش مصنوعی میشود. استفاده دانشجویان از این فناوری بهویژه هوش مصنوعی مولد برای نوشتن پذیرفته شده است. آنها درحال آماده شدن برای مشاغلیاند که در آن، هوش مصنوعی بهطور همهجانبه حضور فعال دارد. کمیته تشخیص میدهد یک خطمشی در مورد استفاده از هوش مصنوعی وجود دارد و باید برای تجدیدنظر یا بهروزرسانی مورد توجه قرار گیرد. دسترسی به برخی ابزارهای LLM برای دانشجویان و دانشکدهها، کاربرد دیگری است که برای هوش مصنوعی در حمایت از دانشگاه مطرح شده است. موضوع دسترسی همگانی به یک یا چند ابزار LLM برای در نظر گرفتن حقوق دانشجویی بارها مورد بحث قرار گرفته است. دسترسی دانشجویان به این فناوری و LLM یک مسئله اساسی محسوب میشود و ممکن است بهعنوان هزینه آموزشی در کمکهای مالی و محاسبات هزینه کالج در نظر گرفته شود.

استفاده از هوش مصنوعی در پژوهش

یکی از کاربردهای هوش مصنوعی در امر پژوهش، در امر نوشتن و نویسندگی است. سیاست فعلی دانشگاه در مورد نویسندگی این گونه است که پژوهشهای چندرشتهای درحال رشد بوده و این ممکن است به دلیل بهروزرسانی برای رسیدگی به مسائل بالقوه، در مورد اسناد بین نویسندگان فردی و هوش مصنوعی باشد. اگرچه مجلات، ناشران و دولت، بدونشک سیاستهایی را در این زمینه ایجاد خواهند کرد، اما استنفورد باید درنظر داشته باشد بیانیههای اولیه تألیف مطابق با ارزشهای دانشگاهی، فرایندها و ارزیابی شایستگیها باشد.

معیار دیگری که در استفاده از هوش مصنوعی در پژوهش مدنظر قرار میگیرد، سوءرفتار است. ابزارهای هوش مصنوعی بهویژه آشکارسازهای سرقت ادبی هوش مصنوعی، در حال حاضر به حجم بالایی از اتهامات منجر میشوند و این امر، بار زیادی را بر منابع دانشگاه در قضاوت این ادعاها ایجاد میکند. سیاست و قوانین سوءرفتار فعلی دانشگاه برای بررسی اتهامات فردی باید مطابق با سیاست جدید فدرال ارزیابی و بهروز شود.

معیار دیگر در امر پژوهش برای به کاربردن هوش مصنوعی، بررسی و نوشتن پیشنهادهاست. تولید محتوا به کمک هوش مصنوعی در طرحهای پژوهشی و بررسی پیشنهادهای تحقیقاتی رواج پیدا کرده است. آژانسهای اعطاکننده گرنت درحال توسعه قوانینی در مورد چنین کاربردهایی از هوش مصنوعیاند. دانشگاه ممکن است بهطور مشابه خطمشی خود را در نظر بگیرد یا دستورالعملهای موجود را تکمیل کند. در حالی که استفاده از هوش مصنوعی ممکن است در طوفان فکری، فرایند ویرایش کپی یا اصلاح پیشنهادهای کمکهزینه بسیار مفید باشد، شاید استفاده از هوش مصنوعی استانداردهای اساسی دانشگاهی را نقض کند.

معیار دیگر، آموزش هوش مصنوعی در مورد کار دانشجویی است. تلاشهای فعالانهای برای آموزش سیستمهای هوش مصنوعی برای ارائه آموزش و ارزیابی کار دانشجویان وجود دارد. این سیستمها اغلب مستلزم حجم زیادی از کار دانشجویی بدون مجوز و فرایندهای تأیید مناسب و در برخی موارد نامناسب یا حتی غیرقانونی است.

آخرین معیار نیز شامل نظارت بر استفاده از دادهها برای تحقیقات هوش مصنوعی است. پژوهشهای هوش مصنوعی اغلب شامل استفاده از مقادیر زیادی از دادههای آموزشی است که ممکن است نگرانیهای قانونی یا اخلاقی داشته باشد. با توجه به اینکه بسیاری از پژوهشهای هوش مصنوعی بهداشتی تحتمقررات فدرالند، دانشگاه باید روند بررسی و ارائه پشتیبانی را برای استفاده مسئولانه و سازگار از دادهها روشن کند.

راهبردهای هوش مصنوعی در دانشگاه کالیفرنیا، برکلی

دانشگاه کالیفرنیا، برکلی در سال 2021، نخستین دانشگاه آمریکایی بود که مجموعهای از توصیهها و دستورالعملها را برای هدایت توسعه اخلاقی و پیادهسازی هوش مصنوعی در سراسر دانشگاه، همراه با راهنمایی در مورد چگونگی عملیاتی کردن اصول در زمینههایی ارائه کرده که بیشترین خطر را برای حقوق فردی ایجاد میکنند. دانشگاه کالیفرنیا، برکلی گزارشی را بر اساس حوزههای کاربردی پرخطر شامل سلامت، منابع انسانی و امنیت مورد بررسی قرار داده و به کاربردهای فعلی و آتی هوش مصنوعی در این حوزهها پرداخته و توصیههایی برای چگونگی عملیاتی کردن اصول هوش مصنوعی در این حوزهها ارائه کرده است.

اصول کاربرد هوش مصنوعی در حوزه سلامت

کارگروه هوش مصنوعی دانشگاه کالیفرنیا، برکلی یک کمیته فرعی بهداشت را به دلیل افزایش علاقه و تأثیر ابزارهای مجهز به هوش مصنوعی در ارتباط با دادهها و خدمات بهداشتی این دانشگاه تشکیل داده است. بسیاری از کاربردهای فعلی و آینده هوش مصنوعی در مراقبتهای بهداشتی در این دانشگاه میتواند بر پزشکان، مدیران و بیماران تأثیر بگذارد. علاوه بر دادههای جمعآوری شده از سوی کمیته فرعی سلامت در مرحله توسعه این پروژه، در نظرسنجیها به اصولی اشاره شده است: شفافیت یکی از اصولی است که باید رعایت شود به طوری که در طراحی مجموعه مراقبتهای ویژه، یک گروه بر اساس یافتههای هوش مصنوعی، دادهها را مهندسی معکوس کردهاند تا بهتر بتوانند عملکرد الگوریتمها را درک کنند. شفافیت در نحوه توسعه الگوریتمها برای جلب اعتماد کاربران و اطمینان به نتایج هوش مصنوعی ضروری است. اصل بعدی، انعطاف و عدم تبعیض است. وفاداری دادههای مورد استفاده برای توسعه الگوریتمهای هوش مصنوعی همچنان یکی از نکات مهم در بهرهمندی از این فناوری در دانشگاه کالیفرنیاست. دادههایی که دارای سوگیری هستند، میتوانند بینظمیهایی را در الگوریتمهای هوش مصنوعی ایجاد کنند. تجزیه و تحلیل قوی محدودیتهای مجموعه دادهها برای درک خطرات تبعیض در استفاده از الگوریتمها ضروری است. اصل دیگر در استفاده از هوش مصنوعی، منفعت و رفاه مشترک است. استفاده از هوش مصنوعی برای تصویربرداری پزشکی، این پتانسیل را دارد که با ارائه مراقبتهای سریعتر و باکیفیت بالاتر به بیماران کمک میکند. استفاده بالینی از هر ابزار مجهز به هوش مصنوعی مستلزم آموزش کارکنان و نظارت منظم بر اطمینان از اثربخشی و سود مستمر برای همه است. اصل دیگر در این بین، حریم خصوصی و امنیت است که برای موفقیت هوش مصنوعی در تصویربرداری پزشکی با توجه به نیاز به آموزش تصاویر پزشکی واقعی بیماران حیاتی است. حذف هویت یک مرحله ضروری است اما تضمینکننده باقی ماندن اطلاعات شخصی نیست و با توجه به اینکه بیمارستانها در معرض حملات سایبری هستند، امنیت دادههای بیماران و سیستمهای هوش مصنوعی اولویت دارد.

اصل دیگر، دقت، قابلیت اطمینان و ایمنی است. این اصل برای هوش مصنوعی در تصویربرداری پزشکی از اهمیت بالایی برخوردار است. این ابزارها که مورد تأیید قرار گرفتهاند، شامل یک ویژگی خودکار بررسی کیفیت هوش مصنوعی است که خطاهای اکتسابی را تشخیص داده و به فناوران هشدار میدهد تا قبل از ارسال تصویر به رادیولوژیست، آنها را بررسی و اصلاح کنند. اعتبارسنجی خارجی یک جنبه کلیدی برای حصول اطمینان از عملکرد فناوری هوش مصنوعی در محیطهای بالینی است. این ابزار باید در تمام مدت استفاده از آن در محیطهای بالینی، مورد نظارت قرار گیرد تا به طور منظم دقت، قابلیت اطمینان و ایمنی استفاده از آن را برای تمام بیماران ارزیابی کنند.

اصول کاربرد هوش مصنوعی در حوزه نیروی انسانی

یکی از حوزههایی که هوش مصنوعی در دانشگاه کالیفرنیا، برکلی مورد استفاده قرار میگیرد، نیروی انسانی است. مناسب بودن استفاده از هوش مصنوعی در فرایند استخدام باید برای برآورده کردن اهداف سراسری این دانشگاه و الزامات انطباق قانونی، که یکی از آنها باید پایبندی به اصول هوش مصنوعی مسئول باشد، مورد ارزیابی قرار گیرد. به عبارتی، هوش مصنوعی باید از استخدام مؤثر و عادلانهتر افرادی حمایت کند که واجد شرایط کسب موقعیتهای مناسب هستند. استفاده از هوش مصنوعی باید به جای اینکه روی سابقه افراد تکیه کند، به درک بهتر ویژگیهای مختلف افراد برای شناسایی صلاحیتها و توانمندیهای واقعی کمک کند. اصل دیگر در این حوزه، ارزشهای انسانی است. اتوماسیون تعاملات با نامزدهای احتمالی، چه از طریق هوش مصنوعی یا فرایند اتوماسیون رباتیک، نباید با زیر سؤال بردن این تعاملات، عاملیتها و حقوق مدنی و انسانی را نقض کند. استفاده از هوش مصنوعی باید با احترام و محافظت از حریم خصوصی و سایر نگرانیهای اجتماعی و قانونی همراه باشد. در اصل شفافیت، واحدهای منابع انسانی باید در مورد زمان و نحوه استفاده از هوش مصنوعی برای استخدام و پتانسیل داوطلبان برای تطبیق رفتار خود بر اساس آن یا اطمینان از ارائه دقیق مدارک خود شفاف باشند. شفافیت باید به گونهای محدود شود که خطر سوءاستفاده افراد پیچیده به لحاظ فناوری را در فرایندهای غیرمنصفانه و مصنوعی جذب و استخدام به حداقل برساند. اصل دیگری که در بحث نیروی انسانی و هوش مصنوعی در این دانشگاه مورد توجه قرار گرفته، منفعت و رفاه مشترک است. استفاده از هوش مصنوعی در فرایند استخدام باید به نفع دانشگاه و متقاضیان باشد، به ویژه افرادی که ممکن است به طور سنتی به عنوان نامزدهای برتر از طریق فرایندهای استخدامی شناسایی نشده باشند اما میتوانند مهارتهای حیاتی را ارائه داده و تنوع را ایجاد کنند. همچنین در اصل حریم خصوصی و امنیت، دانشگاه کالیفرنیا باید بررسی کند که آیا استفاده از هوش مصنوعی، کاندیداهای احتمالی را مجبور میکند تا شیوههای حفظ حریم خصوصی خود را تحریف کنند. این کاندیدها باید در مورد اطلاعات جمعآوری شده آگاه شده و اطلاعات آنها باید تا زمانی که برای تکمیل هدف برای مجموعه آن ضروری است، محفوظ باقی بماند. اصل بعدی، دقت، قابلیت اطمینان و ایمنی است. مجموعه دادهها و الگوریتمهای زیربنایی باید به طور مرتب بهروز شوند تا از دقت و قابلیت اطمینان در فرایند استخدام اطمینان حاصل کنند. استفاده از هوش مصنوعی باید آنچه را انجام دهد که ادعا میکند و نباید مغرضانه یا غیرمنصفانه فرایندها یا نتایج را تحریف کند. اصل دیگر پاسخگویی است و دانشگاه کالیفرنیا باید خود را برای استفاده از هوش مصنوعی در فرایندهای استخدامی ازجمله اجرای روشهای پاسخ و اصلاح مناسب برای استفاده یا نتایج مشکلساز مسئول بداند.

برقراری امنیت

کمیته فرعی هوش مصنوعی و امنیت این دانشگاه برای بررسی گسترده استفاده از هوش مصنوعی، تصمیمگیری الگوریتمی و فناریهای شبکهای در سراسر دانشگاه ایجاد شده است. این کمیته از سیستمهای تشخیص چهره، پلاکخوان خودکار و دادههای رسانههای اجتماعی در بخش امنیت دانشگاه استفاده میکند. مدیران دانشگاهی، اصولی را برای بهرهمندی از این فناوری هوشمند در حوزه امنیتی ارائه کردهاند. در اصل مناسب بودن، دانشگاه باید پیش از به کار بردن فناوری تشخیص چهره، مزایا و خطرات آن را در قیاس با سایر گزینهها ارزیابی کرده و دامنه استفاده مناسب از آن را متناسب با ارزشهای دانشگاه برای کنترل افراد مدنظر قرار دهد. استفادههای مغایر با اصول دانشگاه و موارد مشکوک از این فناوری به دلیل ماهیت بسیار حساس ضبط و ذخیره اطلاعات بیومتریک ممنوع است. هرگونه استفاده از فناوری تشخیص چهره در آینده باید با دقت از منظر حقوق مدنی مورد ارزیابی قرار گیرد. در اصل شفافیت، مطرح شده است که اگر تشخیص چهره مورد استفاده قرار گیرد، استقرار و استفاده از آن باید برای تمام اعضای جامعه دانشگاه کالیفرنیا شفاف شود ازجمله نحوه استفاده از آن، نحوه ذخیرهسازی دادههای ثبت شده و نیز درصورتیکه به هر یک از طرفین اجازه دسترسی به دادههای ضبط شده داده شود، باید به طور شفاف اطلاعرسانی صورت گیرد.

در اصل دقت، انصاف و تعصب نیز با توجه به نگرانیها و سوگیریهای قابل توجهی که توسط نرمافزار تشخیص چهره مطرح میشود، هر نرمافزار تشخیص چهره در آینده باید از نظر دقت، انصاف و سوگیری، با دقت بالا و به طور کامل ارزیابی شود. این ارزیابیها باید از سوی ارزیابهای مستقل در سناریوهای دنیای واقعی انجام شود. در اصل حریم خصوصی نیز در حالی که تشخیص چهره میتواند ابزار مفیدی برای اطمینان از ایمنی در محوطه دانشگاه باشد، مزایای آن باید با حریم خصوصی فردی و آزادیهای مدنی سنجیده شود. به دلیل پیچیدگی ایجاد تعادل بین این تمایلات، توصیه میشود در صورت بهرهمندی از فناوری تشخیص چهره، امکان ارزیابی مکرر و ارزیابی مجدد مزایا و معایب نسبی فراهم شود. در اصل ارزشهای انسانی، با توجه به شیوههایی که نژادپرستی در ایجاد امنیت تأثیرگذار است، استفاده از ابزارهای مبتنی بر هوش مصنوعی در حفظ امنیت باید مورد بازنگری قرار گیرد تا از تعصب بیشتر، تضعیف کرامت انسانی، مداخله در حقوق شهروندی و نقض حقوق بشر جلوگیری شود. جایگزینهای برقراری امنیت مبتنی بر هوش مصنوعی، ازجمله از کار انداختن فناوریهای مجهز به هوش مصنوعی باید در نظر گرفته شود. در اصل منفعت و رفاه مشترک نیز، برقراری امنیت مبتنی بر هوش مصنوعی باید با هدف به ارمغان آوردن منافع عادلانه برای همه باشد. این امر مستلزم توجه به این نکته است که چه کسانی مشمول استفاده از فناوریهای امنیتی مبتنی بر هوش مصنوعی هستند و از آن سود میبرند.